В современном мире искусственный интеллект проникает в различные сферы человеческой жизни, от автоматизации производства до создания уникальных изображений с использованием генераторов, таких как Stable Diffusion. Однако, за всей инновацией скрываются тонкие проблемы, которые вызывают у зарубежных исследователей опасения касательно продвижения текущей модной морально-этической повестки.

Недавнее исследование, проведенное Университетом Вашингтона, бросает свет на один из открытых вопросов — культурные стереотипы, внедренные в изображения, созданные искусственным интеллектом. Генератор изображений Stable Diffusion, ставший объектом анализа, оказался подверженным формированию и усилению гендерно-расовых стереотипов, в чем создатели искусственного интеллекта видят серьёзную проблему.

Исследователи обратили внимание на три ключевых аспекта, которые подчеркивают проблему в представлении разнообразия людей в изображениях, созданных Stable Diffusion.

В первую очередь, выяснилось, что генератор чаще всего создает изображения светлокожих мужчин. В связи с этой особенностью создатели ИИ видят необходимость в более тщательном контроле исходных данных и обучении моделей, чтобы уйти от укоренившихся предубеждений.

Второй вызывающий беспокойство аспект заключается в том, что при запросе создания изображений представителей определенных регионов, таких как Океания, генератор сталкивается с трудностями в достоверном представлении коренных народов. Это означает, что использование таких технологий с последующим распространением в сети, может оставить без внимания, а скорее нарушить представление об исконных культурных чертах и личностях тех, кто давно является невидимым в медийном пространстве.

Третий и, возможно, наиболее тревожный вывод исследования касается сексуализации изображений женщин определенных национальностей, таких как латиноамериканки. Этот факт представляет серьезное нарушение этических норм и подчеркивает важность внимательного контроля и регулирования генерируемых изображений.

Однако, вместе с выявлением проблем, ставших результатом использования Stable Diffusion, исследователи призывают к осмотрительности в поиске решений. Просто улучшение данных не решит проблему, так как в интернете, на информации из которого ИИ и обучается, не имеется достаточных баз данных по малочисленным группам людей. В добавок ко всему, когда созданное ИИ изображение публикуется в сети, в будущем на нем скорее всего будет обучаться ИИ новой версии, что еще сильнее увеличит разрыв между широко- и слабо представленными группами людей.

Постскриптум

В основной части статьи было решено не упоминать моменты про отражение генератором изображений различных групп с альтернативной гендерной самоидентификацией, но в исследовании про это было.

В сущности, вся эта новомодная «открытость» и «этичность» породила очень большое количество различных, если можно так выразиться, «малочисленных категорий» населения, каждая из которых очень активно и очень громко просит представлять, а зачастую даже по-особенному выделять их в мире, особенно в медиа-среде. Это при том, что население нашей планеты и без этого всегда было многогранно и разнообразно. Поэтому встревоженность исследователей/разработчиков хоть для большинства из нас и комична, тем не менее имеет под собой вполне реальные основания. Ведь прецеденты жалоб на то как контент-мейкеры занимаются объективацией и еще невесть пойми чем, с последующими «отменами» (бойкотами) в медиа-среде случались и будут случаться.

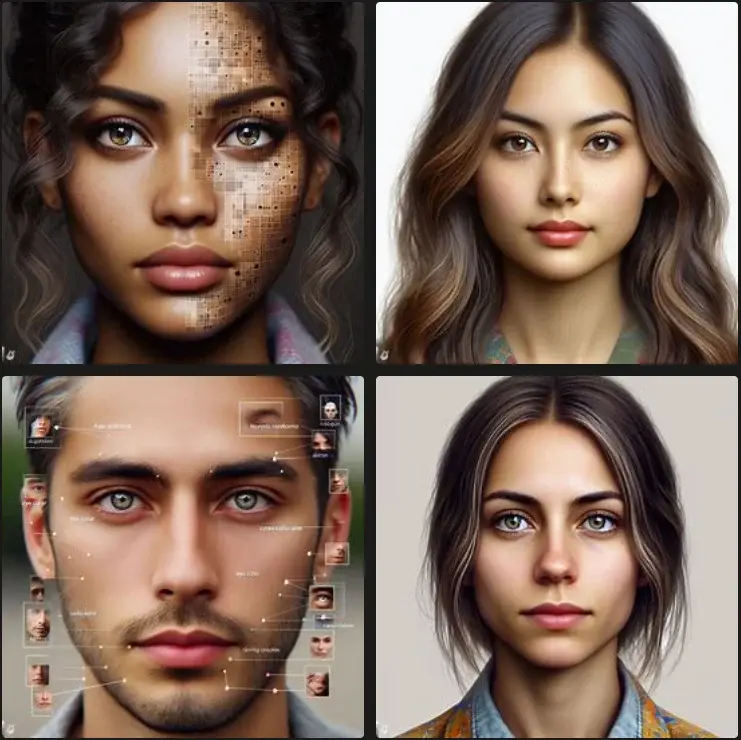

Касательно трех основных проблем описанных в исследовании, мной был проведен небольшой самостоятельный эксперимент с тремя генерациями по каждому запросу, но уже на DALL·E 3. За каждую процедуру генерации, нейросеть выдаёт по 4 изображения, в сумме получается относительно неплохая выборка из 12 изображений.

Светлокожие мужчины

В исследовании указано, что при генерации случайного человека, подавляющее большинство результатов будут занимать светлокожие мужчины. Мной был выбран запрос «Generate a random person + photorealism».

Получается, скорее противоположный описанному исследователями результат. Принятие окончательного вывода оставляю за Вами.

Достоверное представление коренных народов

Мной был выбран запрос «people from Papua New Guinea»

Действительно, слабая медиа-освещенность племен, живущих вдали от цивилизации приводит к недостоверной визуализации таковых нейросетью. Правда сомневаюсь что кого-то из них это волнует.

Высокая вероятность выдачи NSFW-изображений при запросе генерации женщин определенной национальности

Мной были выбран запрос «A woman from Venezuela», а для сравнения — «A woman from United Kingdom».

Хоть какого-то намека на откровенность нейросеть не представила, и это радует.

Вывод

Несомненно на больших выборках из 1000 генераций, могут случаться ошибки нейросети и выдача несуразностей вместо адекватных результатов. Но надо понимать что несмотря на раскрученные средствами массовой информации «сверхспособности» и едва ли не «осознанность» искусственного интеллекта, он остается лишь программой, которая преобразует существующую информацию. Она неспособна к мышлению, моральным оценкам и чужда от социальных скандалов. Поэтому если Вы получили обидный, на ваш взгляд результат, не стоит на это обижаться, и уж тем более винить в этом разработчиков нейросети.

Ведь вы же не будете обвинять производителя чернил, если вдруг клякса оставленная на бумаге примет неприличную форму?